Les pionniers du quantique (partie 1) : le bilan des premières années d'investissement

Le quantique est porté par de grands industriels de la tech, des start-ups ainsi que par la recherche universitaire. Mais aussi par de grands industriels, friands de calcul intensif. Premier bilan des investissements consentis par quatre groupes français : Airbus, Crédit Agricole, EDF et TotalEnergies.

PublicitéCela fait 4 ans, 5 ans, voire davantage que les pionniers du quantique ont commencé à se frotter à cette technologie. On est ici bien loin des 'révolutions' technologiques prêtes à l'emploi que l'industrie de la tech apporte régulièrement sur le marché à grand renfort de marketing. Avec le calcul quantique, on parle bien d'une rupture d'une tout autre ampleur. Car, c'est l'architecture même des systèmes de calcul qui est totalement chamboulée, transformant en profondeur la manière dont on peut interagir avec ceux-ci. Sans oublier le fait qu'on parle encore de systèmes expérimentaux, marqués par des défauts qui en limitent les usages (en particulier les erreurs, nées de l'instabilité des qubits). Ce sont de ces réalités dont témoignent quatre pionniers, trois groupes industriels de grande taille (Airbus, EDF et TotalEnergies), ainsi qu'une des plus grandes banques françaises, le Crédit Agricole.

1. Pourquoi investir dans le quantique ?

Les raisons qui poussent de grandes entreprises à investir dans une technologie encore immature tiennent tant aux limites des supercalculateurs traditionnels qu'au potentiel de la technologie. Potentiel qui peut justement, conduire un pionnier sur la technologie à prendre un avantage compétitif sur un segment clef de son activité. « EDF a recours à de nombreux calculs de simulation de phénomènes physiques, dans le nucléaire, dans l'hydroélectrique, dans les énergies renouvelables ou encore dans les prévisions de production et de consommation. Nous sommes ainsi dans le Top 100 mondial en matière de calcul. Nous nous devions donc de comprendre le potentiel de l'informatique quantique », indique ainsi Stéphane Tanguy, directeur des services et technologies de l'information de la R&D d'EDF, pour expliquer le lancement d'un programme de recherche dédié au quantique voici 5 ans.

Jean-Patrick Mascomère, de la R&D de TotalEnergies-OneTech : « l'accès à la résolution de problèmes inaccessibles avec les techniques actuelles passe par une remise à plat des algorithmes et de leur formulation mathématique ». (Photo : D.R.)

Le constat est similaire chez TotalEnergies qui lui aussi affiche une longue tradition de modélisation de phénomènes physiques sur des calculateurs HPC, notamment pour des applications sismiques. « Nos expérimentations autour de l'informatique quantique s'inscrivent dans cette continuité. Cette technologie très innovante promet de donner accès à la résolution de problèmes inaccessibles avec les techniques de calcul actuelles, au prix d'une remise à plat des algorithmes et de leur formulation mathématique », résume Jean-Patrick Mascomère, le responsable de l'équipe calcul scientifique au sein de la R&D de TotalEnergies-OneTech. Même si ce dernier s'empresse de relever que les ordinateurs quantiques en sont encore à un stade préindustriel. Et que les tests menés jusqu'à présent ne permettent pas encore d'exécuter des calculs que le groupe ne serait pas en mesure de réaliser avec des calculateurs traditionnels. « L'objectif consiste avant tout à préparer nos algorithmes en avance de phase et à mieux comprendre quels domaines vont profiter en premier de l'avantage quantique », reprend Jean-Patrick Mascomère. Par exemple, les architectures quantiques se prêtent bien à la recherche d'un optimum pour certains problèmes complexes, car elles permettent d'explorer un espace de grande dimension en une seule fois. Or, on sait que certains de ces problèmes sont inaccessibles au HPC et qu'ils le resteront demain. Mais nous pensons que, pour nos applications, les premiers problèmes qui bénéficieront du quantique sont plutôt à rechercher du côté des applications de chimie. » C'est d'ailleurs sur ce terrain que TotalEnergies a publié de premiers résultats.

PublicitéUn premier domaine d'expérimentation que le groupe partage avec Airbus, autre géant industriel à avoir lancé un programme d'expérimentations sur la technologie il y a de cela déjà 8 ans ! « Nous avons démarré en étudiant un grand nombre de cas d'usage différents. Schématiquement, on peut les regrouper en quatre groupes : les problèmes d'optimisation, les applications de machine learning, les sujets relatifs à la chimie et la résolution d'équations complexes. Notre objectif était de comprendre les bénéfices qu'Airbus, au travers de ses trois activités principales (l'aviation civile, la défense et le spatial), pourrait retirer de l'informatique quantique, » résume Jasper Simon Krauser, le coordinateur des technologies quantiques chez Airbus. Il indique par ailleurs que le groupe concentre ses efforts sur les goulets d'étranglement ayant un fort impact sur les activités du groupe. Autrement dit, des problèmes où, quand la complexité s'accroît, l'espace des solutions augmente souvent de façon exponentielle. « Sur ces sujets, le HPC classique ne peut plus passer à l'échelle comme ce fut le cas par le passé, car la technologie va se heurter à une limite physique, dit le responsable. Par ailleurs, utiliser l'informatique traditionnelle pour ce type de calculs coûte cher et consomme énormément d'énergie. L'informatique quantique est une des voies - ce n'est pas la seule ! - qui permet d'envisager un dépassement de ces goulets d'étranglement. » Sur les architectures quantiques, la puissance se conjugue donc avec une certaine sobriété énergétique, un autre aspect qui intéresse les grands groupes soucieux de leur impact carbone et de leur image en la matière auprès du grand public. Avant l'été, EDF a d'ailleurs remporté un projet financé par la BPI visant à comparer la consommation du quantique et du HPC sur des cas d'usage tournés vers l'optimisation, pour des résultats équivalents.

L'équipe de la start-up Pasqal fondée en 2019 et issue de la recherche académique française (le prix Nobel de physique 2022, Alain Aspect, fait partie des co-fondateurs). (photo : D.R.)

Dans un secteur très différent - la banque -, on retrouve ces mêmes problématiques de limitation des architectures de calcul actuelles. Pour des besoins évidemment différents, comme le raconte Ali El Hamidi, le responsable adjoint du capital market funding au sein de Crédit Agricole CIB (CACIB) : « au sein de la division des risques, les équipes d'analyse quantitative ont besoin de moyens informatiques pour effectuer les calculs de risques de portefeuille qui nécessitent de prendre en considération un nombre important de facteurs et de projeter les mesures à des échéances lointaines dans le futur. Le recours aux techniques de calcul intensif est indispensable. On retrouve des problématiques similaires dans les salles de marché de capitaux, cette fois pour obtenir une rapidité et une précision suffisantes dans le calcul de prix des produits dérivés, en particulier pour les plus complexes d'entre eux. » Pour ces applications, CACIB utilise les dernières technologies en matière de calcul (comme des GPU ou des TPU pour l'entraînement des réseaux de neurones). Mais l'organisation doit, malgré tout, introduire des hypothèses permettant de simplifier les modèles, « au prix d'un compromis acceptable sur la précision des calculs. »

Dans ce contexte, comme l'indique Ali El Hamidi, « une nouvelle technologie comme le quantique représente à la fois une opportunité, mais également un risque de rupture pour la banque ». C'est ce qui a décidé CACIB à explorer le potentiel de la technologie dès 2019, en s'appuyant sur la richesse de l'écosystème en France, avec l'appui de sociétés de conseil, du monde académique et d'industriels spécialisés dans la technologie, tant sur le volet matériel que logiciel. « D'emblée, il s'agissait de voir dans quelle mesure la technologie dans son état présent pouvait répondre à certains besoins concrets de la banque », dit le responsable. La stratégie a donné naissance à une feuille de route, comprenant plusieurs étapes, dont l'objectif ultime est l'exploitation, par ses propres moyens, d'un ordinateur quantique.

2. Les défis que rencontrent les pionniers

Au sein de CACIB, la première étape de cette feuille de route - l'expérimentation - a été menée à bien au travers de deux projets conduits en parallèle dès mi-2021. Pour ce faire, l'établissement de Montrouge (Hauts-de-Seine) s'est reposé sur deux partenaires, Pasqal, un fabricant français d'ordinateurs quantiques, et Multiverse Computing, une société espagnole spécialisée dans les algorithmes inspirés du quantique. « L'objectif de départ consistait bien à tester la technologie, à vérifier si ses promesses étaient au rendez-vous, avec la volonté d'apporter à notre banque de la valeur sur chacun des deux projets. Notre but n'était pas de chercher un éventuel avantage quantique. Modestement, nous pensions que cela pouvait être visé dans un deuxième temps, une fois que la technologie aura été testée avec succès sur des problèmes que nous savons déjà résoudre par les outils conventionnels. Il faut accepter de travailler par étapes », dit Ali El Hamidi.

Et, pour nos interlocuteurs, une de ces étapes clefs consiste à maîtriser l'algorithmie, la façon de formuler les problèmes pour une architecture quantique donnée. Car, contrairement à l'informatique classique, sur les systèmes quantiques, le logiciel reste intimement lié à la machine sous-jacente. « Dans le passage à ce type d'architecture, le défi principal consiste à reformuler nos problématiques avec des algorithmes quantiques, confirme Jean-Patrick Mascomère, de TotalEnergies. Même si des classes d'algorithmes quantiques sont déjà bien répertoriées, traduire nos problèmes opérationnels dans cette logique, en leur donnant la bonne taille pour l'adapter à la puissance disponible, demeure complexe. » Les experts en place, habitués au HPC, n'expriment pas encore les problèmes qu'ils tentent de résoudre dans les termes attendus par un ordinateur quantique. « Y parvenir nécessite à la fois une compréhension des phénomènes physiques et une connaissance de l'algorithmie quantique. C'est d'ailleurs pour cela que nous avons testé le quantique très tôt, afin de nous inscrire dans une logique de construction des compétences et des savoirs, construction qui nécessite des années », reprend la responsable de l'équipe calcul scientifique du géant de l'énergie.

Ce même défi est souligné par Stéphane Tanguy, d'EDF. « Cela n'a rien à voir avec l'algorithmie classique. Or nous possédons notre propre patrimoine de codes » fonctionnant sur des systèmes HPC. Un patrimoine que l'énergéticien entend adapter aux architectures quantiques, afin d'en évaluer les performances. « Nous nous sommes très vite rendu compte que les algorithmes sur étagère n'étaient pas adaptés à nos attentes. Nous avons donc dû faire les maths, en formant des équipes constituées de doctorants et de chercheurs connaissant nos problématiques métiers », souligne le responsable. EDF a ainsi validé sa capacité à porter les codes développés sur un simulateur quantique. Avant d'aborder actuellement une seconde étape, qui consiste à porter ces codes sur différentes architectures quantiques. « Si les résultats sont au rendez-vous, nous irons ensuite chercher l'accélération quantique en production, en mettant en oeuvre un environnement hybride mélangeant HPC et accélérateur quantique », assure Stéphane Tanguy. Une longue route ; un constat partagé par tous les spécialistes avec qui nous avons échangé.

Sans oublier les lacunes intrinsèques du quantique, en particulier l'instabilité des qubits. « En l'état actuel de la technologie, les résultats que nous obtenons sur des systèmes quantiques sont bruités, autrement dit souffrent de problèmes de fiabilité, dit Jean-Patrick Mascomère. Par ailleurs, ils n'alignent encore qu'un nombre limité de qubits - de l'ordre d'une centaine -, ce qui contraint la complexité des problèmes que nous pouvons adresser. Et ces limitations ne vont pas être levées tout de suite. »

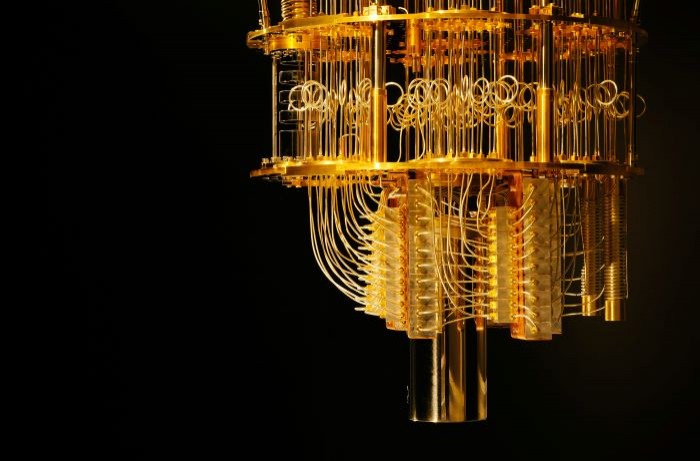

Le laboratoire d'informatique quantique d'IBM, dans l'État de New York, aux États-Unis. (Photo : IBM)

De son côté, Jasper Simon Krauser, d'Airbus, souligne les difficultés qu'il faudra encore éliminer avant d'envisager l'implémentation d'un algorithme quantique dans un processus opérationnel. « Ce n'est pas simple ! Intégrer ce type de calcul dans une application en production demande beaucoup d'efforts. Il faut optimiser l'application de calcul et assurer son intégration dans un environnement applicatif hybride, où informatiques quantique et traditionnelle sont appelées à cohabiter. Dans le secteur aérospatial, où les systèmes doivent être validés et certifiés par les autorités, une telle perspective doit être anticipée », souligne-t-il.

Face à ces multiples défis, les pionniers du quantique soulignent la nécessité de travailler en écosystème, en impliquant des acteurs du logiciel, du middleware et du matériel, mais aussi d'autres entreprises utilisatrices. « Vous avez bien sûr besoin de spécialistes et de l'implication de nombreux métiers, pour avoir accès aux connaissances sur les cas d'usage que vous testez. Mais le plus important, c'est d'intégrer un écosystème plus large », confirme Jasper Simon Krauser. Ne serait-ce qu'en raison des incertitudes qui planent encore : face à une technologie encore trop expérimentale pour que des architectures standards se dégagent, mieux vaut conserver plusieurs fers au feu.

3. Le bilan des expérimentations

Bien entendu, les pionniers de la technologie ont tout intérêt à vanter un bilan positif de leurs investissements dans le quantique. Pour autant ni Airbus, ni CACIB, ni EDF, ni TotalEnergies ne versent dans le triomphalisme. Avant tout, nos interlocuteurs ont le sentiment d'avoir franchi de premières étapes et de préparer l'avenir. « Sur la première phase de notre

programme, nous sommes satisfaits. Quelque part, à l'origine, c'était un peu un pari, car les algorithmes sur étagère ne fonctionnaient pas sur nos problématiques. Et nous avions besoin d'un niveau de mathématiques très poussé pour créer nos propres codes quantiques, » résume Stéphane Tanguy, qui lui aussi se félicite du travail en écosystème mis en oeuvre dans le cadre de ce programme, en impliquant les constructeurs ou industriels évidemment (comme Pasqal, Candela, IBM ou Atos, qui a fourni l'émulateur), mais également la recherche publique et des start-ups.

Chez Airbus, Jasper Simon Krauser et son équipe sont en train de regrouper les différents cas d'usage en fonction de la nature des mathématiques qui les sous-tendent. « Nous nous focaliserons ensuite sur ceux qui sont susceptibles d'avoir le plus d'impact pour l'entreprise et sur ceux qui sont susceptibles de passer à l'échelle », dit le responsable. Ce dernier n'en souligne pas moins que parmi les trois technologies quantiques - les communications quantiques, les capteurs quantiques et le calcul quantique -, c'est cette dernière qui affiche le niveau de maturité le plus faible. « Avec l'ordinateur quantique, nous sommes donc dans une phase exploratoire des cas d'usage les plus prometteurs, tout en testant les capacités des différents matériels et en nous essayant à l'algorithmie quantique, via des approches inspirées par le quantique (les réseaux de tenseurs notamment, NDLR), via de la programmation sur des machines NISQ* et en examinant aussi les options tolérantes aux erreurs », résume Jasper Simon Krauser, qui indique toutefois que son équipe est sur la bonne voie pour disposer d'une première application commerciale démontrant un avantage quantique. « L'échéance dépendra des progrès réalisés sur le matériel. Cela sera probablement pour des problèmes de simulation portant sur des modélisations microscopiques, comme des réactions chimiques. À moins que cet avantage quantique ne provienne d'abord du machine learning exploitant l'amélioration quantique », indique le coordinateur du sujet au sein du groupe aéronautique.

Stéphane Tanguy, directeur des services et technologies de l'information de la R&D d'EDF : « Nous avons l'espoir d'être prêts à déployer l'accélération quantique dès que les architectures compteront aux environs de 100 qubits ». (Photo : D.R.)

TotalEnergies également envisage de tester de nouveaux cas d'usage, dans la continuité de ses premières recherches tournées vers la chimie, en s'ouvrant davantage à des problématiques d'optimisation, par nature plus tolérantes aux phénomènes d'instabilité des qubits. Nous étudions également des partenariats pour mieux cartographier les possibilités des différents algorithmes et technologies. Mais nous n'avons aucune certitude quant à un éventuel passage en production d'un algorithme quantique. Parmi les spécialistes de la technologie, on évoque un horizon allant de 5 à 10 ans pour voir les premiers bénéfices quantiques se matérialiser en avantages industriels concrets. Cette incertitude est d'ailleurs une réelle difficulté pour un industriel comme TotalEnergies dans le dimensionnement de son effort de recherche sur le sujet, mais les perspectives que propose cette technologie de rupture nous motivent à poursuivre nos travaux », indique Jean-Patrick Mascomère. Des perspectives qui pourraient, à terme, concerner une des activités clefs de TotalEnergies : les calculs des structures géologiques, indispensables dans les phases d'exploration de nouveaux gisements. « Si les systèmes quantiques parviennent à accélérer ou à rendre plus précis nos calculs de simulation de phénomènes physiques, par exemple sismiques, cela représenterait évidemment un changement majeur pour notre activité, dit le responsable. Mais on parle ici de classes de problèmes, basés sur la résolution d'équations différentielles, d'une complexité bien supérieure encore aux recherches d'optimum. »

A plus court terme, tant CACIB qu'EDF envisagent, à moyenne échéance, de premiers passages en production d'algorithmes quantiques, pour accélérer un calcul bien précis dans un processus bien plus large, qui continuerait à être traité par des ordinateurs classiques. « D'ici trois ans, nous pensons passer à la phase 3 de notre programme, en commençant à implémenter les cas d'usage les plus prometteurs en production, sur des architectures hybrides. Et ce, même si les machines quantiques restent imparfaites. Nous avons l'espoir d'être prêts à déployer l'accélération quantique, dès que les architectures compteront aux environs de 100 qubits », résume Stéphane Tanguy, le directeur des services et technologies de l'information de la R&D d'EDF. Chez CACIB, passé les deux premiers projets (voir ci-dessous), la banque étudie à présent « les possibilités d'obtenir un avantage quantique dans certaines procédures intégrant des problèmes d'optimisation. »

Retrouvez le second volet de notre article, consacré aux résultats des premiers projets lancés par Airbus, CACIB, EDF, TotalEnergies ainsi que par la Matmut, autour des technologies quantiques

* NISQ, pour Noisy Intermediate Scale Quantum, est un type d'ordinateur quantique imparfait (bruité) de taille intermédiaire.

En complément

- Les DSI de la finance se préparent à un avenir dopé au quantique

Article rédigé par

Reynald Fléchaux, Rédacteur en chef CIO

Suivez l'auteur sur Twitter

Commentaire

INFORMATION

Vous devez être connecté à votre compte CIO pour poster un commentaire.

Cliquez ici pour vous connecter

Pas encore inscrit ? s'inscrire