Entraînement des IA : un besoin de puissance multiplié par 4 chaque année

Chaque année, la puissance nécessaire à l'entraînement des grands modèles d'IA est multipliée par un facteur allant de 4 à 5. Deux fois plus vite que la loi de Moore ! Une fuite en avant peu pérenne, en termes de coûts, de consommation d'énergie et d'impact carbone.

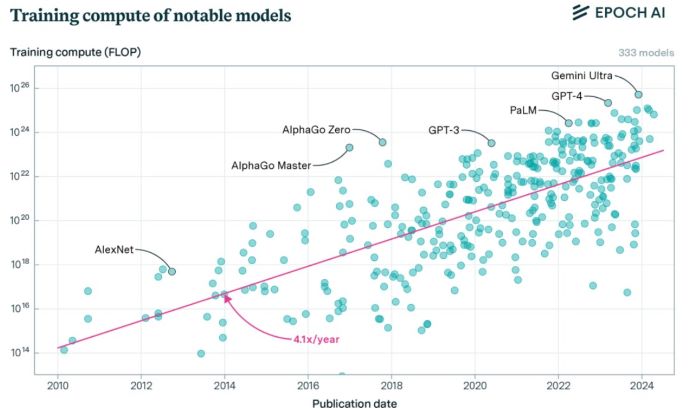

PublicitéSelon une étude menée par Epoch AI, la capacité de calcul nécessaire à l'entraînement des modèles d'IA, est multipliée par plus de 4 chaque année, sur une période allant de 2010 à aujourd'hui (voir ci-dessous). Soit un rythme deux fois supérieur à celui de la loi de Moore, qui a présidé à l'évolution de l'informatique depuis les années 70 et qui prévoit un doublement de la puissance délivrée par les microprocesseurs tous les deux ans.

Selon le cabinet d'études, cet accroissement des besoins atteint même un facteur 5 si on se focalise sur les LLM les plus performants. Ainsi, pour entraîner Gemini Ultra, Google a mobilisé une capacité de calcul frôlant les 10 puissance 26 Flops. Soit, en termes d'ordre de grandeur, plus de 3 années de calcul sur un supercalculateur exaflopique (d'une puissance de l'ordre de 10 puissance 18). Le Forum économique mondial estime, de son côté, que la puissance de calcul nécessaire pour soutenir l'essor de l'IA double environ tous les 100 jours.

Des coûts multipliés par 2 à 3 chaque année

Ce constat a évidemment un impact direct sur les coûts de développement de ces modèles. Dans une autre étude, datant de juin, le même cabinet Epoch AI estime que le coût d'entraînement des modèles d'IA de pointe a augmenté d'un facteur de 2 à 3 par an au cours des huit dernières années. Ce qui signifie, en prolongeant la courbe, que les plus grands modèles coûteront plus d'un milliard de dollars en développement d'ici à 2027, essentiellement en matériel nécessaire à leur entraînement et aux tests. Reste à trouver le marché permettant d'amortir ces investissements colossaux !

La croissance de la taille de ces modèles a également des conséquences majeures en termes de consommation d'énergie, tant pour la phase d'entraînement que pour l'inférence, du fait de la croissance des usages. L'énergie nécessaire à l'exécution des tâches d'IA connaît déjà un taux de croissance annuel compris entre 26 % et 36 %. « Cela signifie que d'ici 2028, l'IA pourrait consommer plus d'énergie que l'Islande tout entière en 2021 », souligne le Forum économique mondial. Pour Jack Gold, analyste chez J. Gold Associates, la pression sur la demande en électricité va augmenter les tarifs, mais ce sont les utilisateurs qui vont, in fine, payer la note. « Oui, AWS paie un milliard de dollars par an en factures d'électricité, mais ses clients lui versent 2 milliards de dollars par an. C'est ainsi que fonctionne le commerce », observe l'analyste.

PublicitéCentrale nucléaire + datacenter

Selon des sources citées par le Wall Street Journal, cette course à la puissance, donc à l'énergie, pousse les géants du numérique à se rapprocher de la filière nucléaire. Un tiers des producteurs d'électricité américains exploitant des centrales nucléaires sont en pourparlers avec des entreprises IT pour fournir de l'électricité à leurs derniers datacenters dédiés à l'IA. Ainsi, Amazon Web Services devrait conclure un accord en ce sens avec Constellation Energy. Une filiale d'Amazon a également dépensé 650 M$ pour acheter, en Pennsylvanie, un datacenter alimenté par l'énergie nucléaire à Talen Energy, et prévoit de construire 15 nouveaux datacenters sur son campus qui seront également alimentés par cette énergie décarbonée, selon The Citizen's Voice, un journal basé en Pennsylvanie.

Ce virage vers le nucléaire répond aussi à un autre objectif pour les acteurs de l'IA : réduire leur empreinte carbone et atteindre leurs objectifs environnementaux. Microsoft et Google ont récemment reconnu un dérapage de leur trajectoire carbone, précisément en raison de la croissance de l'IA. La firme de Redmond a vu ses émissions de CO² déraper de près de 30% en 2023 par rapport au niveau de référence, mesuré en 2020. En grande partie en raison de la construction et du fonctionnement de datacenters répondant à la demande de ses clients en matière de cloud, mais aussi d'IA. Constat similaire chez Google où en 2023, les émissions carbone ont progressé de 13% par rapport à 2022, à rebours des ambitions que s'était fixé la firme de Mountain View.

Article rédigé par

Reynald Fléchaux et Jacques Cheminat

Commentaire

INFORMATION

Vous devez être connecté à votre compte CIO pour poster un commentaire.

Cliquez ici pour vous connecter

Pas encore inscrit ? s'inscrire